Nuove sfide nel training di modelli linguistici su larga scala

Mentre la ricerca sull’IA continua a concentrarsi sulla risoluzione di problemi sempre più complessi, uno dei cambiamenti più significativi è la scala di calcolo necessaria per addestrare i modelli linguistici di grandi dimensioni (LLM). Tradizionalmente, l’addestramento dei nostri modelli di raccomandazione richiedeva un numero relativamente ridotto di GPU per molti modelli diversi. Con l’avvento dell’IA generativa (GenAI), siamo passati a meno lavori ma estremamente grandi, richiedendo un ripensamento dell’infrastruttura software, hardware e di rete.

Le sfide del training su larga scala

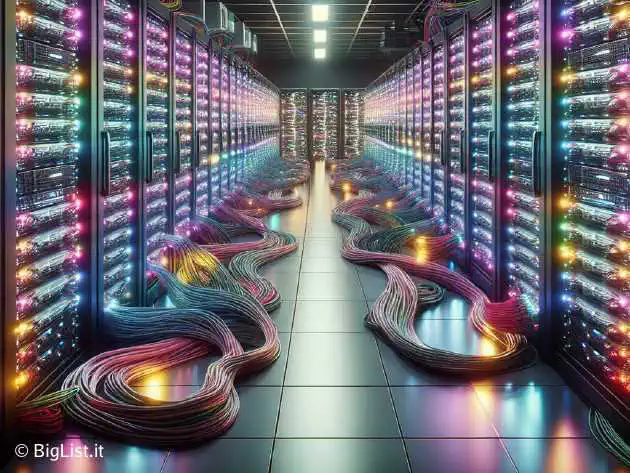

Aumentando il numero di GPU necessarie per un lavoro, la probabilità di interruzioni dovute a guasti hardware aumenta. È importante garantire l’affidabilità dell’hardware attraverso rigorosi controlli di qualità e automazione per rilevare e risolvere rapidamente i problemi. Dobbiamo essere in grado di recuperare rapidamente dai guasti riducendo il sovraccarico di riprogrammazione e inizializzazione del training. Preservare efficacemente lo stato di training e riprendere dall’ultimo checkpoint è cruciale. Infine, la connettività ottimale tra le GPU richiede un’infrastruttura di rete robusta e ad alta velocità, oltre a protocolli e algoritmi efficienti di trasferimento dati.